Flowers-17 데이터 세트

17 개의 서로 다른 꽃의 품종을 인식하는 세분화 된 분류 과제입니다. 이미지 데이터 세트는 매우 작으며 총 1,360개의 이미지에 대해 클래스 당 80개의 이미지 만 있습니다. 컴퓨터 비전 작업에 딥러닝을 적용 할 때 일반적인 경우는 클래스당 1,000 ~ 5,000개의 데이터를 갖는 것이므로 여기서는 확실히 큰 부족함이 있습니다.

모든 범주가 매우 유사하기 때문에 Flowers-17을 세분화 된 분류 작업이라고 부릅니다 (즉, 꽃의 품종). 사실, 우리는 이러한 각 범주를 하위 범주로 생각할 수 있습니다. 범주는 확실히 다르지만 상당한 양의 공통 구조를 공유합니다.

세분화 된 분류 작업은 우리의 기계 학습 모델이 매우 유사한 클래스를 구별하기 위해 극도로 구별되는 기능을 학습해야 함을 의미하기 때문에 딥러닝 실무자에게 가장 어려운 경향이 있습니다. 이 세분화된 분류 작업은 제한된 훈련 데이터를 고려할 때 더욱 문제가됩니다.

Aspect-aware Preprocessing

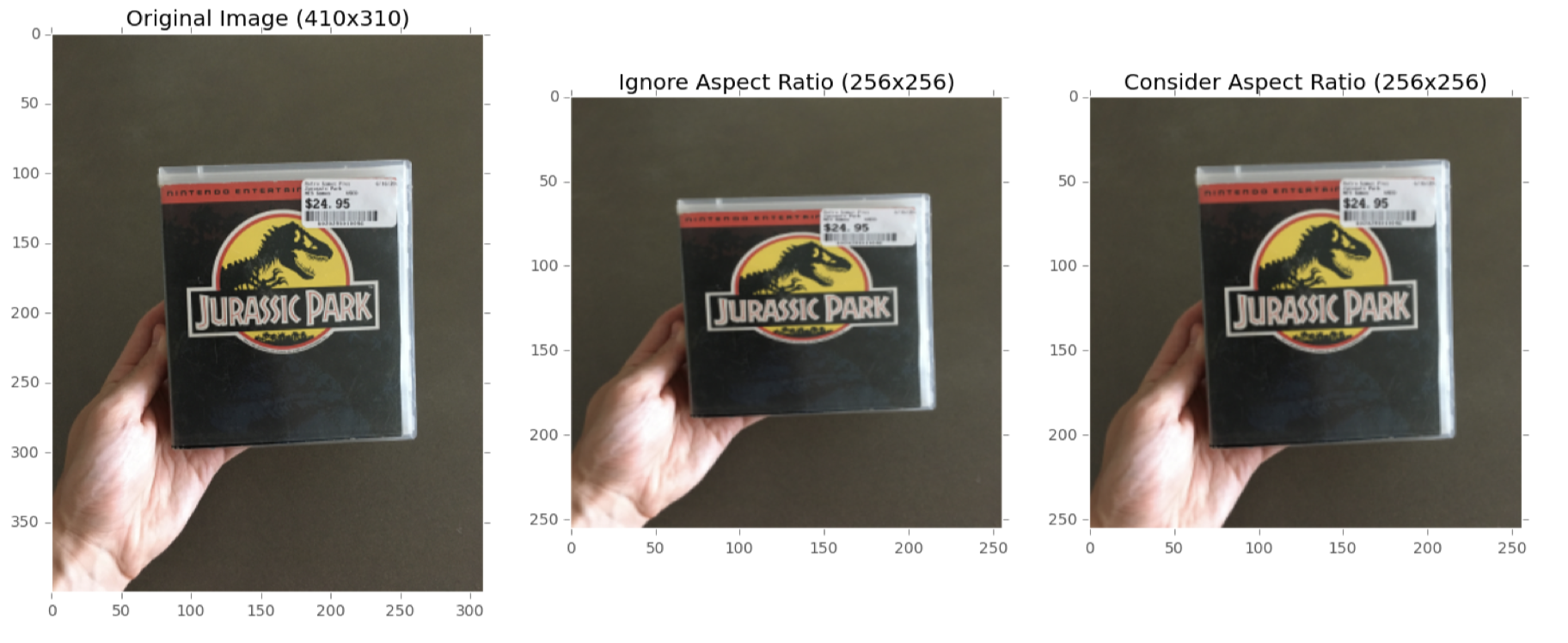

지금까지는 영상비를 무시하고 고정 된 크기로 크기를 조정하여 이미지를 전처리했습니다. 일부 상황, 특히 기본 벤치 마크 데이터 세트의 경우 그렇게하는 것이 허용됩니다.

그러나 더 까다로운 데이터 세트의 경우 고정된 크기로 크기를 조정해야하지만 종횡비는 유지해야합니다.

왼쪽에는 고정 된 너비와 높이로 크기를 조정해야하는 입력 이미지가 있습니다. 가로 세로 비율을 무시하고 이미지 크기를 256 × 256 픽셀 (중간)로 조정하여 원하는 크기에 맞도록 이미지를 효과적으로 찌그러 뜨리고 왜곡합니다. 더 나은 접근 방식은 이미지의 종횡비 (오른쪽)를 고려하는 것입니다. 여기서 너비가 256 픽셀이되도록 더 짧은 치수를 따라 크기를 조정 한 다음 높이를 따라 이미지를 잘라 높이가 256 픽셀이되도록합니다.

자르는 동안 이미지의 일부를 효과적으로 버렸지 만 이미지의 원래 종횡비도 유지했습니다. 일관된 종횡비를 유지하면 Convolutional Neural Network가보다 차별적이고 일관된 기능을 학습 할 수 있습니다.

aspect-aware 전처리가 어떻게 구현되는지 확인하기 위해 AspectAwarePreprocessor를 만들어보겠습니다.

생성자는 이미지 크기를 조정할 때 사용되는 보간 방법과 함께 두 개의 매개 변수 (대상 출력 이미지의 원하는 너비 및 높이)가 필요합니다.

# import the necessary packages

import imutils

import cv2

class AspectAwarePreprocessor:

def __init__(self, width, height, inter=cv2.INTER_AREA):

# store the target image width, height, and interpolation

# method used when resizing

self.width = width

self.height = height

self.inter = inter

그런 다음 아래에서 전처리 기능을 정의 할 수 있습니다.

def preprocess(self, image):

# grab the dimensions of the image and then initialize

# the deltas to use when cropping

(h, w) = image.shape[:2] # 입력 이미지의 너비와 높이를 잡고

# 더 큰 치수를 따라자를 때 사용할 델타 오프셋을 결정

dW = 0

dH = 0즉, AspectAwarePreprocessor()는 2단계 알고리즘입니다.

1. Step # 1 : 가장 짧은 치수를 결정하고 이에 따라 크기를 조정합니다.

2. Step # 2 : 대상 너비와 높이를 얻기 위해 가장 큰 치수를 따라 이미지를 자릅니다.

다음 코드 블록은 너비가 높이보다 작은 지 확인하고, 그렇다면 너비를 따라 크기를 조정합니다.

# if the width is smaller than the height, then resize

# along the width (i.e., the smaller dimension) and then

# update the deltas to crop the height to the desired # dimension

if w < h:

image = imutils.resize(image, width=self.width, inter=self.inter)

dH = int((image.shape[0] - self.height) / 2.0)

그렇지 않고 높이가 너비보다 작 으면 높이를 따라 크기를 조정합니다.

else:

image = imutils.resize(image, height=self.height, inter=self.inter)

dW = int((image.shape[1] - self.width) / 2.0)

이제 이미지의 크기가 조정되었으므로 너비와 높이를 다시 잡고 델타를 사용하여 이미지 중앙을 잘라야합니다.

# now that our images have been resized, we need to

# re-grab the width and height, followed by performing

# the crop

(h, w) = image.shape[:2]

image = image[dH:h - dH, dW:w - dW]

# finally, resize the image to the provided spatial

# dimensions to ensure our output image is always a fixed

# size

return cv2.resize(image, (self.width, self.height), interpolation=self.inter)잘라낼 때 (반올림 오류로 인해) 이미지 대상 이미지 크기가 ± 1 픽셀만큼 벗어날 수 있습니다. 따라서 출력 이미지가 원하는 너비와 높이를 갖도록 cv2.resize를 호출합니다. 그런 다음 전처리 된 이미지가 호출 함수로 반환됩니다. AspectAwarePreprocessor()를 구현 했으므로 이제 Flowers-17 데이터 세트에서 MiniVGGNet 아키텍처를 학습 할 때 작동하도록하겠습니다.

'keras > 1.Data Augmentation' 카테고리의 다른 글

| 3. Flowers-17: With Data Augmentation (0) | 2020.08.21 |

|---|---|

| 1. Data Augmentation (0) | 2020.08.20 |